第五代英特尔至强,专注AI加速

第五代英特尔至强铂金 8592+处理器凭借更优化的SoC,三倍更大缓存和更快内存,在运行诸多工作负载时具备与众不同的优势,尤其是AI工作负载。

优点:

· 主流型号上拥有额外的八个核心

· 高端型号上的三级缓存容量增大了三倍

· 在AI工作负载中具备领先性能

· 在多线程和轻线程工作负载中均有出色表现

· 支持英特尔AMX、AVX-512、VNNI和BFloat 16

· 支持CXL Type 3存储设备

英特尔数据中心产品始终具备与众不同的优势。于去年12月最新推出的第五代英特尔至强可扩展处理器(以下简称第五代至强),在一众基准测试中,展现出强大性能提升。而且,这款最新产品的发布也展示出英特尔正在持续推动自身产品路线图发展并践行对客户的承诺。

第五代至强的旗舰型号上比上一代增加了四个核心,为双插槽服务器提供高达128核心和256线程。其三级缓存亦增加三倍,并为高性能型号配备了更快的DDR5-5600。结合其它有针对性的改进,包括对芯片架构的更新设计,相较上一代产品,第五代至强可将AI推理性能提升42%,可在进行通用计算时将整体性能提升高达21%,并在一系列客户工作负载中将每瓦性能提升高达36%。

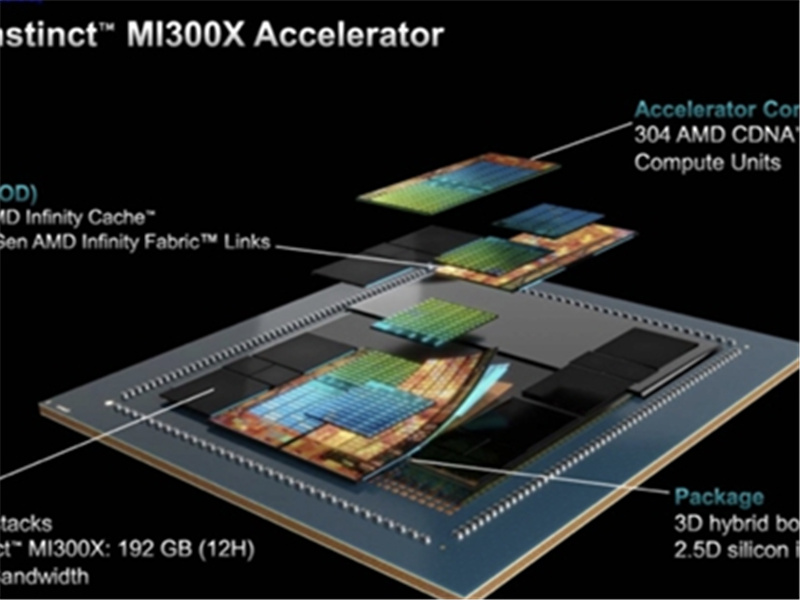

第五代至强采用Intel 7制程工艺,是该节点的升级版本,并使用了增强版的Raptor Cove微架构。第五代至强拥有许多创新和设计升级,远超我们对新一代产品的期待。其中,英特尔从第四代至强芯片的复杂四芯粒设计,转变为更简单的双die设计,总共包含610亿个晶体管,新的die提供了更一致的延迟性。尽管经过重新设计,第五代至强仍然与现有的四代至强Eagle Stream平台的兼容性,从而缩短了验证时间,使新的处理器能够快速在市场上应用。

第五代至强在整体核心数量上虽然并未创造业界纪录,但英特尔的芯片仍能满足大部分市场的需求,而且得益于其内置加速器和在AI工作负载中的性能表现,英特尔能够以兼具性能和能效的优势组合赢得更多客户青睐。

第五代英特尔至强处理器规格和售价

第五代英特尔至强处理器系列包括32个SKU,主要分为六类,包括为云、网络、存储、长使用寿命、单路通用及液冷通用。该系列也被划分为铂金、金、银和铜四个子等级。值得注意的是,第五代英特尔至强可扩展处理器最多支持双路,没有八插槽版本。但同时,英特尔还提供了不同级别的内存支持,八通道速度从DDR5-4400扩展到DDR5-5600。

英特尔为每种类型的工作负载都设置了不同的SKU,第五代至强的32个SKU较之有52个SKU的上一代至强,在产品组合上已经精简了很多。

对于第五代至强,英特尔继续推动加速技术的发展,这些技术可以直接购买或通过“即用即付”的模式进行购买。芯片上专门设计的几大加速器区域旨在大幅提升多种工作的性能,例如压缩、加密、数据移动和数据分析,而这些工作通常需要使用独立的加速器才能展现出领先性能。每个芯片都可以启用不同数量的加速器“设备”,但“+”型号的芯片默认情况下每种类型的加速器都至少启用一个。

第五代至强标准型号的TDP从125W到350W不等,但液冷通用的版本则最高可达385W。

第五代至强铂金8592+拥有64核心和128线程,比60个核心的第四代至强8490H多了四个核心。然而,8592+比第四代通用旗舰型号8480+多了八个核心。

正如其后缀“+”所表示的,8592+激活了内置的每一个加速器。额外付费后,每种加速器都可以升级到四个加速处理单元,这通常由原始设备制造商提供,因此价格有所不同。

8592+的核心基频为2.0 GHz,但可以在所有核心上提升到3.0 GHz,或在单个核心上提升到3.8 GHz。该芯片配备了320MB的L3缓存,大小是上一代产品的三倍多。英特尔提升三级缓存容量的决定将有利于运行多种工作负载,但也有个前提条件。正如我们将在下文中介绍的,第五代至强处理器可以采用三种不同的芯片配置,只有最高端的芯片配置(40个核心及以上)才具有三倍的缓存容量。与此同时,32核及更低的型号所使用的芯片通常与上一代处理器的缓存容量相同。

至强处理器现在在1DPC(每通道一个DIMM)模式下最高支持DDR5-5600,在2DC模式下支持DDR5-4800,比上一代的DDR5-4800有所改进。英特尔还将UPI链路调整为20GT/s,比以前的16 GT/s略有提高。

所有的第五代至强都具备以下特性:

lLGA4677插槽/ Eagle Stream平台

l超线程

l八通道DDR5内存:顶配型号运行速度高达DDR5-5600(1DPC)和DDR5-4800(2DPC),但速度会因型号而异

l80个PCIe 5.0通道

l每个插槽最高6TB内存

l支持CXL Type 3内存

lAMX,AVX-512,VNNI,BFLOAT 16

lUPI速度从16 GT/S提高到20 GT/S

AI工作负载

生成式AI的热议度与日俱增,但数据中心中使用的人工智能模型多种多样。尽管目前,我们仍然使用GPU来训练AI大模型和运行大多数大型生成式AI模型。然而,大多数AI推理一直在数据中心CPU上运行,我们预计这一趋势不仅会继续,而且还会稳步攀升。

AI领域的发展瞬息万变,因此要对其在数据中心里的性能进行标准化衡量始终具备挑战性。而且,批处理大小和其他测试参数在实际部署中也会有所不同。因此,在这些并没有优化到我们在实际部署中期望的水平的时候,如下基准测试仅供参考。而一些数据中心和企业会采用现成的AI模型进行微调,因此,虽然该方法适用于通用性能测试,但所采用的模型等因素也会相应不同。

显然,英特尔启用 AMX、AVX-512、VNNI 和 Bfloat16 等AI增强功能,为AI用户奠定了坚实的基础。在TensorFlow ResNet-50测试中,第五代至强8592+的速度比64核的第四代霄龙9554快18%,但在AlexNet和GoogLeNet模型中,这两款芯片的速度不相上下。令人惊讶的是,96核的第四代霄龙9654在三个TensorFlow工作负载中均排名垫底,这意味着其chiplets阵列可能无法为此类模型提供最低延迟和最佳可扩展性。

在MLpack中,我们发现8592+在完成任务的速度上,比两款用于对比的其他处理器都要快40%。三个ONNX推断基准测试也都突显出第五代至强内置加速器的优势。

关键的是,我们注意到第五代至强在除了GoogleNet模型外的所有工作负载中,相对于上一代60核的8490H都有了大幅度的性能提升。因此整体来看,第五代至强的性能表现出众。而从其他一些第三方基准测试中可以看出,AMX为英特尔在利用指令集的模型中提供了显著的领先优势。正如我们在许多基准测试中看到的,更高的核心数量并不是所有类型工作负载的万能选择——尤其是在像AI这样对延迟敏感的工作负载中。

第五代至强利用其AI加速等内置的加速引擎,为广泛工作负载提供了显著优势。而且,第五代至强在包括AI工作负载在内的多个工作负载中均具备领先优势,这也为即将在2024年推出的具备多达288核心的Sierra Forest,以及紧随其后发布的Granite Rapids奠定了良好的基础。

声明:

- 该内容为网络收集,不代表荣登网观点或立场,版权归原作者所有。

- 平台仅提供信息存储服务,如发现文章、图片等侵权行为,请联系我们删除。

- 如对本稿件有异议或投诉,请联系:755277197@qq.com

推荐文章: